注: 以下の翻訳の正確性は検証されていません。AIPを利用して英語版の原文から機械的に翻訳されたものです。

バッチビルドとインタラクティブビルド

Code Workbook をインタラクティブに使用し、ワークブックインターフェース内からジョブを実行すると、すべてのジョブはワークブックに関連付けられた Spark モジュールを使用します。下の画像でわかるように、任意のセッションのセッション履歴ダイアログで Spark モジュール ID を表示できます。

各ユーザーには、同じプロジェクト内の同じ環境でワークブック間で使用される 1 つの Spark モジュールが割り当てられるため、インタラクティブジョブは別のワークブックからの他のジョブが完了するのを待ってキューに入れられることがあります。例えば、同じモジュールで最大 5 つの Python ジョブが同時に実行できます。6 つ目のジョブは "Code Workbook でキューイング" と表示されます。

バッチビルド内では(例えば、スケジュールされたビルドやデータセットプレビューからのビルドなど)、ビルド内の環境ごとに 1 つの Spark モジュールが使用されます。例えば、スケジュールされたビルドに複数の Code Workbook 内で作成されたデータセットが含まれていて、これらの Code Workbook がすべて同じ環境を使用している場合、ビルドはすべてのジョブで同じ Spark モジュールを使用します。インタラクティブジョブはその Spark モジュールにルーティングされません。

出力がデータセットとして保存されることを望む場合や、コードを反復処理するために一つ一つの変換を実行しない場合は、バッチビルドを使用することをお勧めします。これには以下のようなケースが含まれます。

- 同じワークブックや、同じインタラクティブ Spark モジュールを使用する他のワークブックで、長時間実行される変換をビルドしたい場合。

- データセットを定期的に更新したい場合。例えば、新しい入力データがある場合や、毎日午前 9 時に更新されたデータを見たい場合は、スケジュールされたバッチビルドを使用してください。

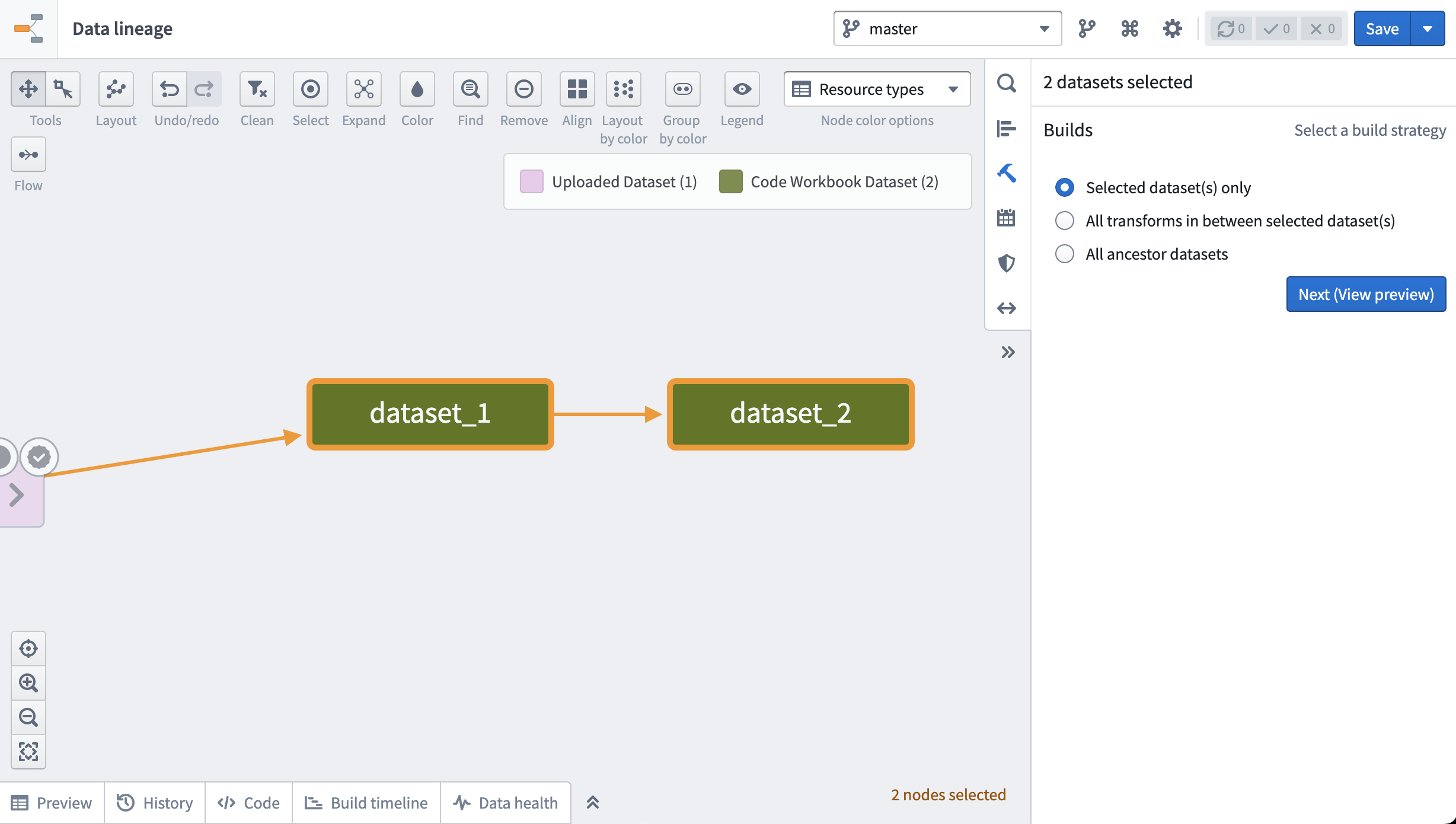

ワークブックから、データセットを開くを使用してデータセットプレビューでデータセットを表示し、画面右上のビルドボタンを使用してビルドします。複数のデータセットをビルドするには、ページ上部の歯車アイコンに移動し、データフローを確認するを選択します。次に、ビルドしたいデータセットを選択し、右のサイドバーでそれらをビルドする選択肢を選択します。

あるいは、同じサイドバーでカレンダーアイコンをクリックし、データセットのビルドを定期的に実行するスケジュールを設定します。スケジュールの設定方法について詳しくはこちら。

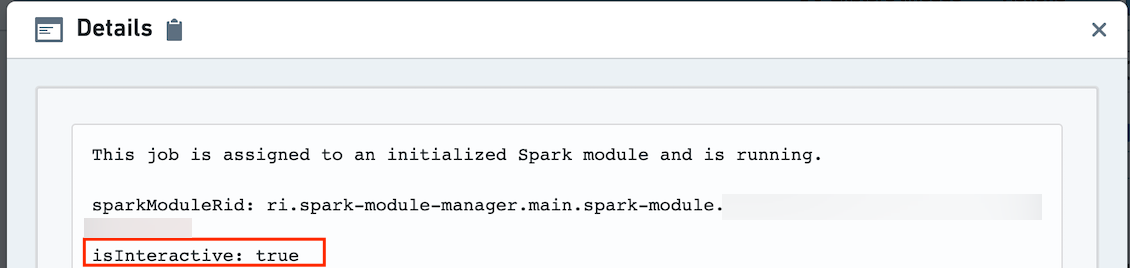

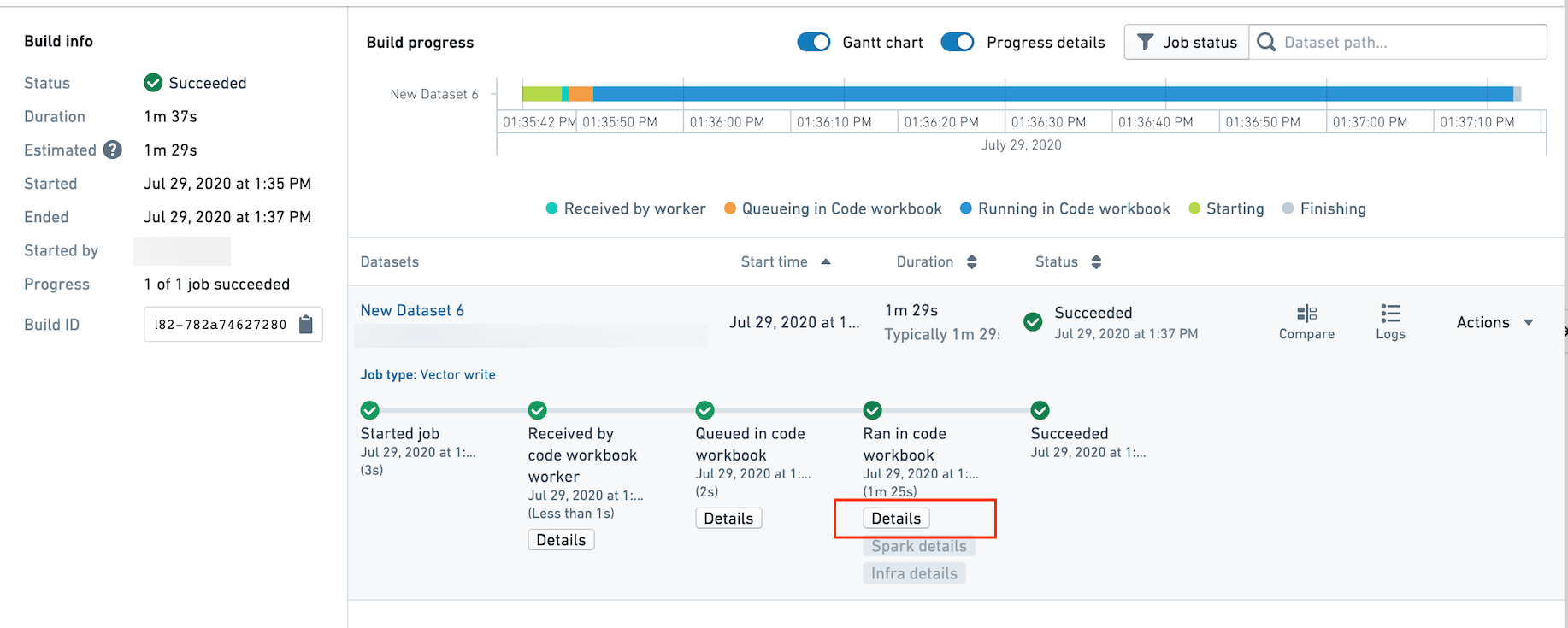

ジョブがバッチビルドモードでビルドされているかインタラクティブモードでビルドされているかを確認するには、ビルドアプリケーションに移動し、「詳細」ボタンをクリックします。

詳細には、Spark モジュールの ID と、isInteractive が true かどうかが記載されています。true の場合、ジョブはインタラクティブモードで実行されています。false の場合、ジョブはバッチビルドモードで実行されており、インタラクティブジョブとは Spark モジュールを共有していません。