注: 以下の翻訳の正確性は検証されていません。AIPを利用して英語版の原文から機械的に翻訳されたものです。

Modeling Objectives 設定

Modeling Objectives には、以下に説明するような多くの設定オプションがあります。Modeling Objectives ホームページから右上の Modeling Objectives 設定 をクリックすることで、Modeling Objectives 設定ページに移動できます。

チェック

Objective チェックは、モデルが運用化される前に事前定義された品質チェックを通過することを確認する方法です。Objective チェックの詳細は、全てのサブミッションのチェック設定方法のドキュメンテーションを参照してください。

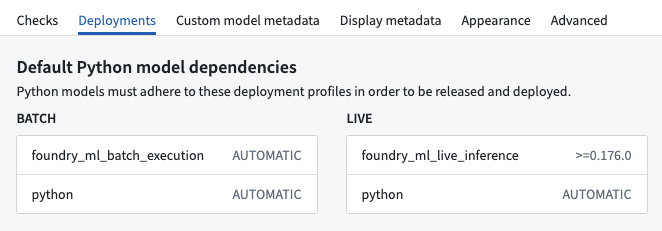

デプロイメント

デプロイメント設定ページでは、Python モデルのサブミッションがバッチまたはライブデプロイメントで運用化される前に必要なモデルサブミッションのデプロイメントプロファイル要件を定義します。

モデルのメタデータ

Modeling Objectives にサブミットされたモデルは、Modeling Objectives 内にモデルサブミッション固有のメタデータを持つことができます。そのメタデータは、モデルに関する関連情報が追跡されることを確認するために、特定の目的のために設定できます。完全な設定詳細については、目的メタデータの設定方法のドキュメンテーションを参照してください。

表示

表示設定では、個々の Modeling Objectives がライトモードまたはダークモードで表示されるかどうかを設定できます。

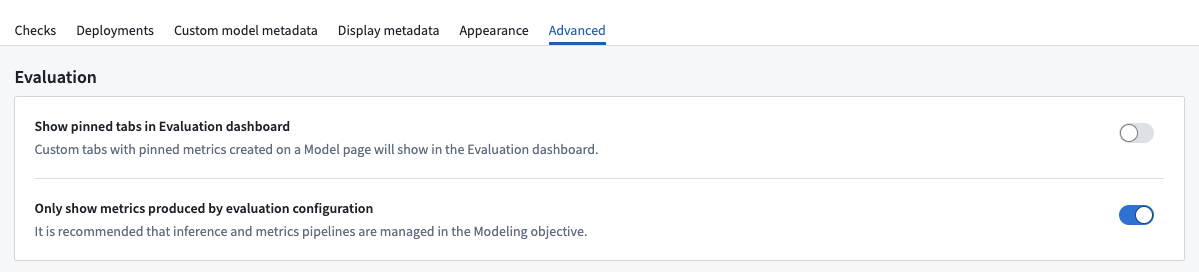

アドバンスド

アドバンスド設定ページには、標準ではない設定オプションがあります。通常、Modeling Objectives のアドバンスド設定は調整するべきではありません。これらの設定は、レガシー機能との後方互換性を保つために提供されています。

評価設定

評価ダッシュボードには2つのアドバンスド設定オプションがあります:評価設定によって生成されたメトリクスのみを表示すると評価ダッシュボードにピン留めタブを表示する。

評価設定によって生成されたメトリクスのみを表示する

Modeling Objectives が評価設定によって生成されたメトリクスのみを表示するように設定されている場合、評価設定を経由して作成されたメトリクスのみが評価ダッシュボードに表示されます。私たちは、Modeling Objectives のモデルに対する標準的な評価プロセスを確保するために、この設定を有効化することをお勧めします。この設定が有効化されていない場合、表示されるモデルのメトリクスが最新であるかどうか、Modeling Objectives が知ることはできません。

レガシーのパイプライン管理経由で設定されたメトリクスのパイプラインは、評価設定によって生成されたメトリクスのみを表示するがオフになっていない限り、表示されません。

評価設定がリリースされる前に設定された Modeling Objectives や、コードで定義されたメトリクスを持つ非プロダクションの Modeling Objectives など、特定の状況では、Modeling Objectives の評価設定の外部からメトリクスを表示することが望ましい場合があります。これはこの設定で有効化できます。

評価ダッシュボードにピン留めタブを表示する

必要に応じて、Modeling Objectives の評価ダッシュボードは、評価ダッシュボードのサブセットタブと並べてカスタムメトリクスビューを表示するように設定できます。

レガシーパイプライン管理

レガシーパイプライン管理は廃止された機能です。推論とメトリクスのパイプラインを設定するためには、評価設定の使用をお勧めします。レガシーパイプライン管理から評価設定への移行を強くお勧めします。

推論とメトリクスデータセットの命名

レガシーメトリクスパイプライン管理によって生成されたデータセットは、複数の Modeling Objectives が同じ出力フォルダー内に推論とメトリクスのデータセットを作成した場合、命名の競合を引き起こし、予期しない動作を引き起こす可能性がありました。これは、更新された評価ダッシュボードと設定で解決されています。

後方互換性を維持するために、レガシーの推論とメトリクスデータセットの命名スキームを使用することが可能です。

更新された命名規則:

- 推論データセット:

inference_<Model Submission Name>_<Evaluation Dataset Name>-<Generated Hash> - メトリクスデータセット:

metrics_<Model Submission Name>_<Evaluation Dataset Name>_<Evaluation Library Name>-<Generated Hash>

レガシー命名規則:

- 推論データセット:

<Model Submission Name> inference - メトリクスデータセット:

<Model Submission Name> metrics