注: 以下の翻訳の正確性は検証されていません。AIPを利用して英語版の原文から機械的に翻訳されたものです。

ダイレクトモデルデプロイメントを作成する

ダイレクトモデルデプロイメントは、モデルを Workshop や Slate などのユーザーアプリケーションに直接接続するライブホステッドエンドポイントです。ダイレクトモデルデプロイメントは、モデルに関数 を使用した TypeScript でのクエリや、REST API コールを介して外部システムからクエリされます。

以下のセクションでは、ダイレクトモデルデプロイメントの作成、構成、および公開方法について説明し、開始する前に確認すべきデバッグ手順と機能の考慮事項について説明します。

1. ダイレクトモデルデプロイメントを作成する

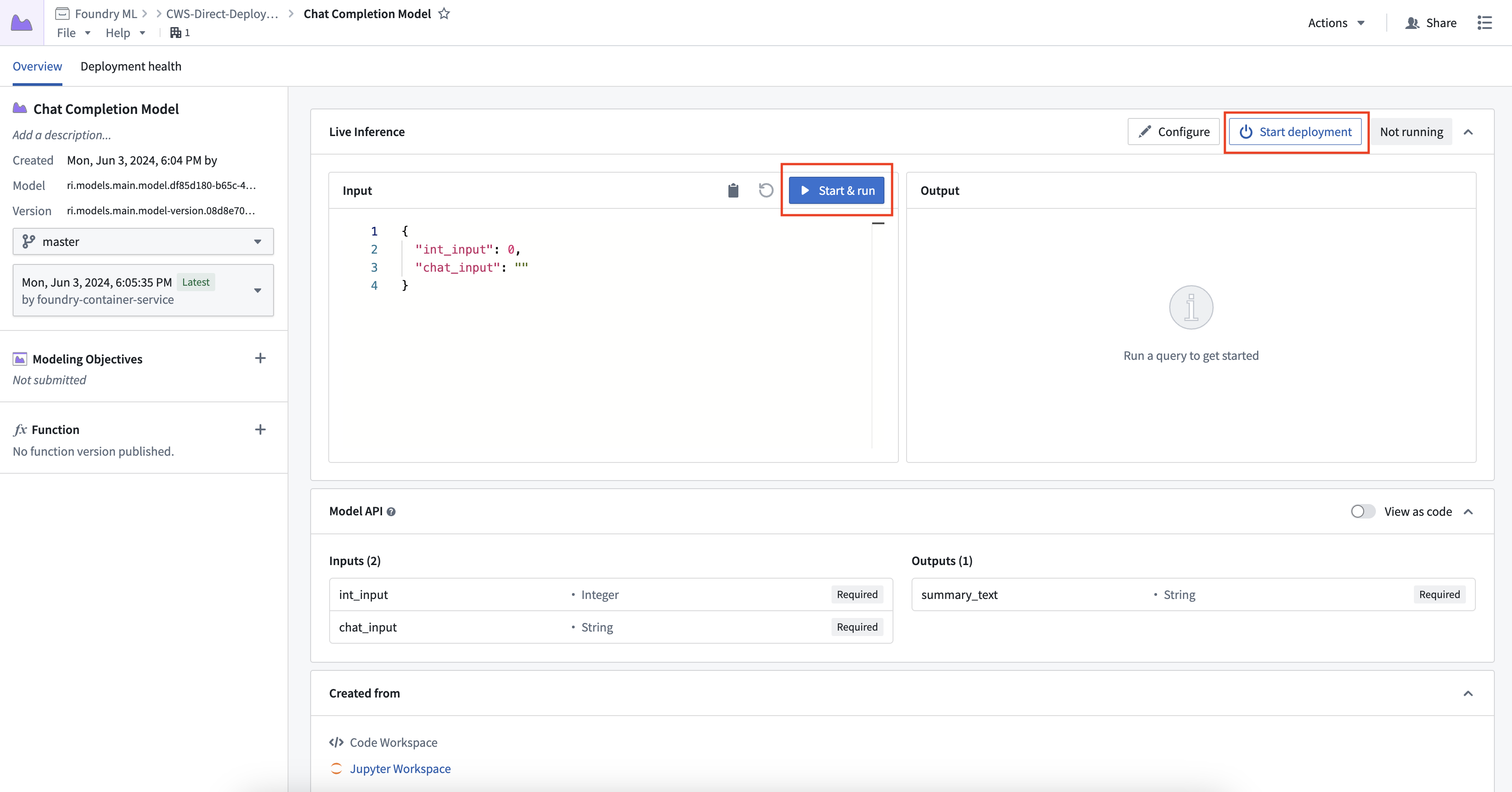

ダイレクトモデルデプロイメントを作成して開始するには、model に移動します。モデルページの上部にある Live Inference の下の Start Deployment を選択します。起動後、Run を選択してデプロイメントを対話的にテストできます。

2. ダイレクトモデルデプロイメントを構成する

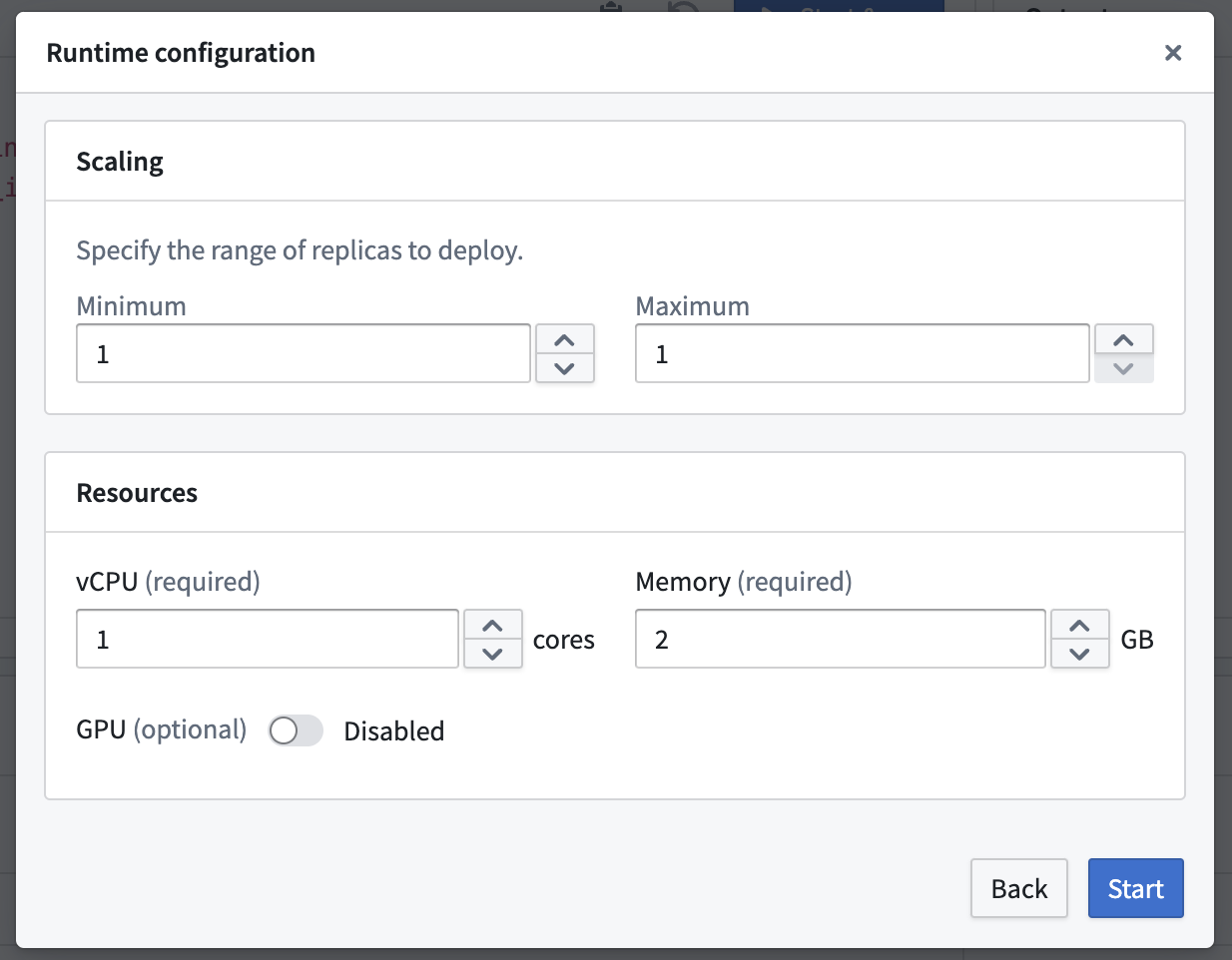

ダイレクトモデルデプロイメントのリソースを構成するには、Live Inference パネルの右上にある Configure ボタンを選択します。ダイレクトモデルデプロイメントは、ゼロからスケールするように構成できます。デプロイメントが 70% の容量に達すると、ランタイムスケーリング構成で指定された最大レプリカ数に達するまで追加のレプリカを作成します。また、45 分間ライブリクエストがない場合、デプロイメントは自動的にスケールダウンします。

3. 関数を公開する

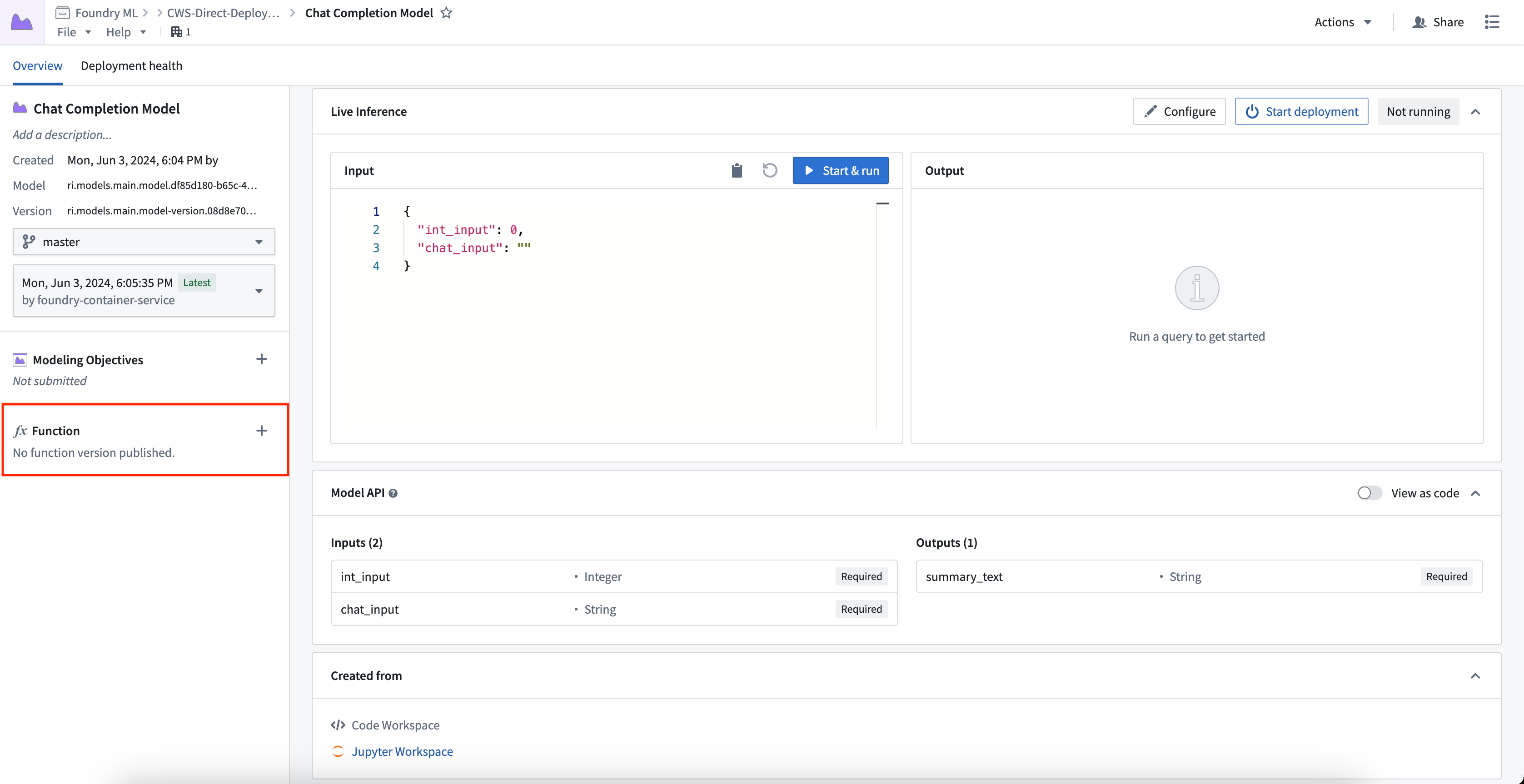

ノーコード関数としてモデルを登録するには、モデル製作物のサイドバーで plus アイコンを選択し、モデル関数名を提供します。ユーザーはブランチごとに 1 つの関数を登録できます。

ブランチ間で関数の名前を同様にすることをお勧めします。たとえば、メインブランチで Plane Detection Model を使用し、開発ブランチで Plane Detection Model [Develop] を使用することができます。

自動アップグレード

各ブランチの model に対して 1 つのダイレクトモデルデプロイメントを作成できます。新しいモデルバージョンがそのブランチに公開されると、ダイレクトモデルデプロイメントはダウンタイムなしで新しいエンドポイントに自動的にアップグレードされます。自動アップグレードを望まない場合は、モデリングの目的ライブデプロイメント を使用することを検討してください。

自動垂直スケーリング

ダイレクトモデルデプロイメントは compute modules を利用しているため、ユーザーが指定した最小および最大レプリカ範囲間での自動水平スケーリングをサポートしています。

モデル API の型安全性

ダイレクトモデルデプロイメントは、すべての推論リクエストに対して型安全性を強制し、モデル API の型が入力型と一致することを保証します。型安全性は、特に以下の入力型に対して尊重されます。

- 数値値: モデルの API が

int型として定義されており、3.6 の値がモデルに渡される場合、0.6 は切り捨てられ、入力は 3 になります。 - 日付とタイムスタンプ: ダイレクトモデルデプロイメントは、

predict()メソッドに提供される前に日付とタイムスタンプ型をキャストします。タイムスタンプフィールドは、ISO 8601 形式の文字列を期待します。 - 強制された API 構造: ダイレクトモデルデプロイメントは、モデル API で必須としてマークされたフィールドを明示的に要求します。

モデルの型安全性は、現在型キャストをサポートしていないライブモデリングデプロイメントとは異なります。

ダイレクトモデルデプロイメントをデバッグする

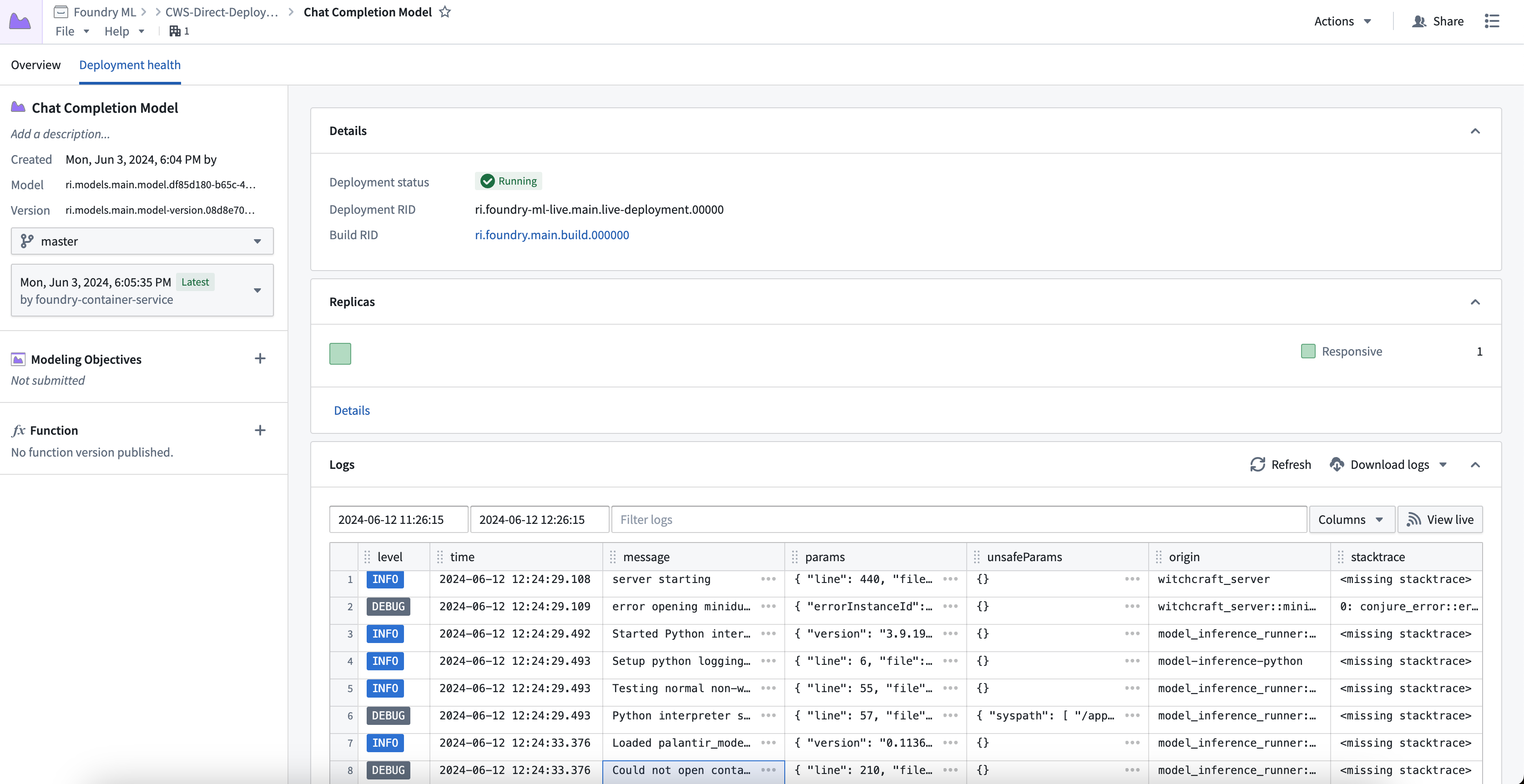

ダイレクトモデルデプロイメントのデバッグ情報とログを表示するには、モデルページの上部にある Deployment health タブを選択します。ここでは、デプロイメントの実行中のビルド、レプリカの状態に関するヘルス情報、ログ、および各レプリカの状態に関するメトリクスを見つけることができます。

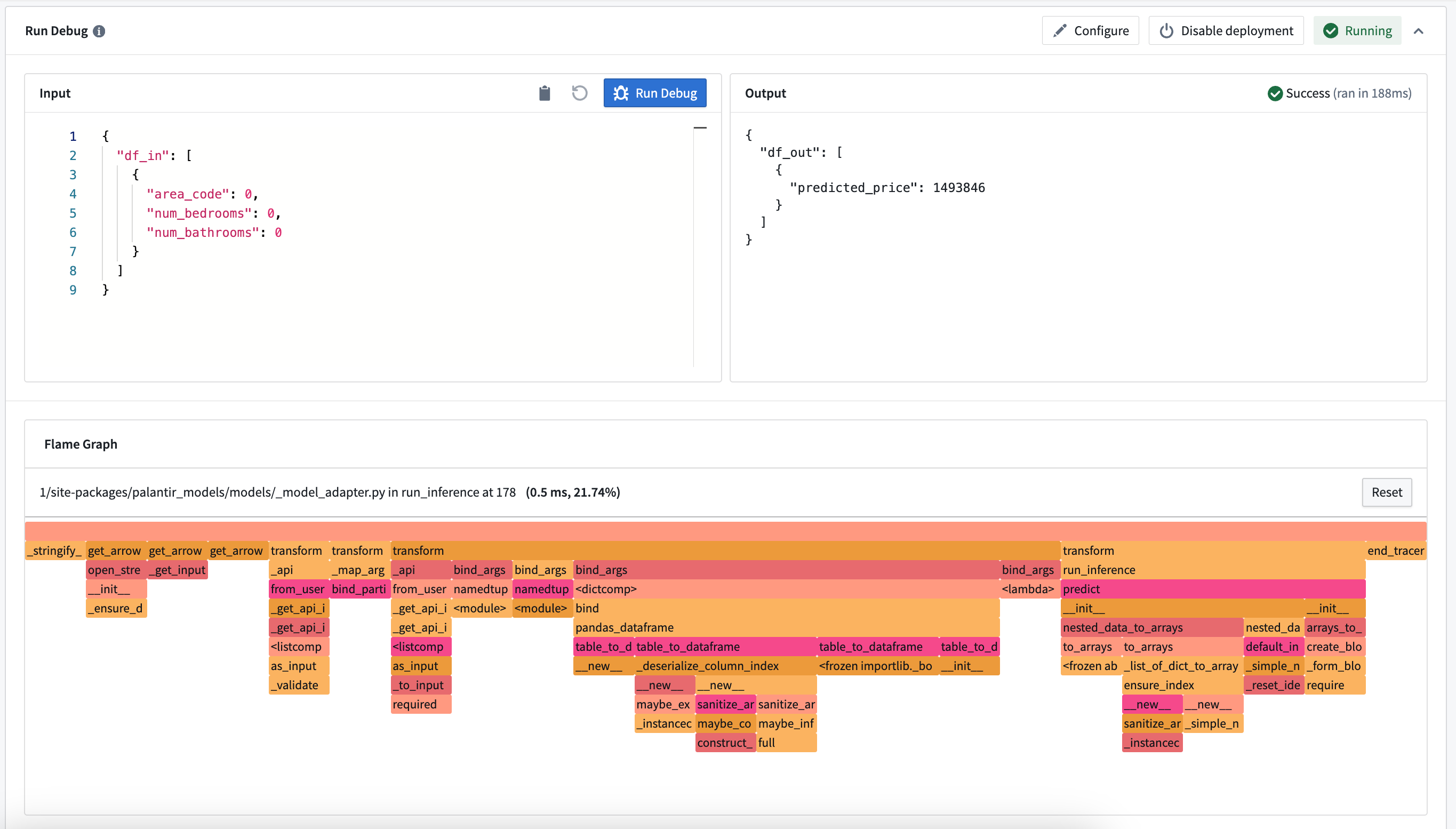

Run Debug カードの下でモデル推論のコールスタックを表示することもできます。これにより、各 Python 関数がどのくらいの時間を要したか、およびどこでパフォーマンスの改善ができるかを確認できます。

Note: これは、コンテナモデルでのコールスタックや推論中にエラーが発生した場合には表示されません。

比較: ダイレクトモデルデプロイメント vs モデリングの目的ライブデプロイメント

ダイレクトモデルデプロイメントの利用可能な機能は、モデリングの目的ライブデプロイメントの機能と異なります。詳細については、以下の表を確認してください。

| 機能 | ダイレクトモデルデプロイメント | モデリングの目的ライブデプロイメント |

|---|---|---|

| 自動アップグレード | はい | いいえ |

| 自動スケーリング | はい | いいえ |

| 型安全性 | はい | いいえ |

| サポートされているエンドポイント | はい (V2 のみ) | はい (V1 および V2) |

| モデル推論履歴 | いいえ | はい |

| プレリリースレビュー | いいえ | はい |

| 自動モデル評価 | いいえ | はい |

| Code Repositories でトレーニングされた | はい | はい |

| Code Workspaces でトレーニングされた | はい | はい |

| コンテナイメージをサポート | はい | はい |

| 外部ホストモデルをサポート | いいえ | はい |

| Spark model adapter API 型 | いいえ | はい |

| Marketplace サポート | いいえ | いいえ |